اخیراً یکی از کاربران ما در بخش نظرات از ما نکاتی در مورد نحوه بهینه سازی فایل robots.txt برای بهبود سئو سایت را خواسته بود.

فایل Robots.txt به موتورهای جستجو می گوید که چگونه وب سایت شما را بخزند که این امر، آن را به یک ابزار سئو فوق العاده قدرتمند تبدیل می کند.

در این مقاله از وبلاگ آذردیتا به شما نشان خواهیم داد که چگونه یک فایل robots.txt عالی برای سئو در وردپرس ایجاد کنید.

فایل robots.txt چیست؟

Robots.txt یک فایل متنی است که صاحبان وب سایت می توانند آن را ایجاد کنند تا به ربات های موتور جستجو نحوه خزیدن و فهرست بندی صفحات (ایندکس کردن) در سایت خود را بگویند و معمولاً در پوشه اصلی وب سایت شما ذخیره می شود.

فرمت اصلی یک فایل robots.txt به شکل زیر است :

User-agent: [user-agent name] Disallow: [URL string not to be crawled] User-agent: [user-agent name] Allow: [URL string to be crawled] Sitemap: [URL of your XML Sitemap]

همچنین می توانید چندین خط دستورالعمل برای مجاز یا غیرمجاز کردن URL های خاص داشته باشید و چندین نقشه سایت اضافه کنید. اگر URL را غیر مجاز قرار ندهید (Allow)، رباتهای موتور جستجو فرض را بر این میگیرند که مجاز به خزیدن در آن مسیر و لینک هستند.

به عنوان مثال :

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /wp-admin/ Sitemap: https://example.com/sitemap_index.xml

در مثال فایل robots.txt بالا، ما به موتورهای جستجو اجازه دادهایم تا فایلها را در پوشه آپلود وردپرس (uploads) ما بررسی و ایندکس کنند.

پس از آن در خط بعدی، ما رباتهای جستجو را از خزیدن و ایندکس افزونهها (plugins) و پوشه مدیریت وردپرس (wp-admin) منع کردهایم.

در نهایت در خط آخر، ما URL نقشه سایت XML خود را ارائه کرده ایم.

آیا برای سایت وردپرس خود به فایل Robots.txt نیاز دارید؟

اگر فایل robots.txt ندارید، موتورهای جستجو همچنان وب سایت شما را می خزند و ایندکس می کنند. با این حال، شما نمی توانید به موتورهای جستجو بگویید که کدام صفحات یا پوشه ها را نباید ایندکس کنند.

هنگامی که برای اولین بار وبلاگی را راه اندازی می کنید و محتوای زیادی ندارید، این تأثیر چندانی نخواهد داشت. با این حال، همانطور که وب سایت شما رشد می کند و محتوای زیادتری میگذارید، احتمالاً می خواهید کنترل بهتری بر نحوه خزیدن و ایندکس شدن وب سایت خود داشته باشید.

ربات های جستجو دارای سهمیه خزیدن برای هر وب سایت هستند.

این به این معنی است که آنها تعداد مشخصی از صفحات را در طول یک بررسی میخزند. اگر خزیدن تمام صفحات سایت شما را به پایان نرسانند، در جلسه بعدی باز می گردند و خزیدن و جستجو در مطالب را از سر می گیرند.

این می تواند نرخ نمایه سازی وب سایت یا ایندکسینگ شما را کاهش دهد.

میتوانید این مشکل را با جلوگیری از تلاش رباتهای جستجو برای خزیدن در صفحات غیرضروری مانند صفحات مدیریت وردپرس، فایلهای افزونه و پوشه تمها برطرف کنید.

به این صورت که، با غیر مجاز کردن صفحات غیر ضروری، سهمیه خزیدن خود را ذخیره می کنید. این به موتورهای جستجو کمک می کند تا صفحات بیشتری را در سایت شما بخزند و آنها را در سریع ترین زمان ممکن فهرست کنند.

یکی دیگر از دلایل خوب برای استفاده از فایل robots.txt زمانی است که می خواهید موتورهای جستجو را از ایندکس کردن یک پست یا صفحه در وب سایت خود منع کنید.

این امن ترین راه برای مخفی کردن محتوا از عموم مردم نیست، اما به شما کمک می کند تا از نمایش آنها در نتایج جستجو جلوگیری کنید.

یک فایل Robots.txt ایده آل چگونه است؟

بسیاری از وبلاگ های محبوب از یک فایل robots.txt بسیار ساده استفاده می کنند. محتوای آنها ممکن است بسته به نیازهای سایت متفاوت باشد :

User-agent: * Disallow: Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

این فایل robots.txt به همه رباتها اجازه میدهد تا همه محتوا را فهرستبندی کنند و پیوندی به نقشههای سایت XML وبسایت در اختیارشان قرار میدهد.

برای سایت های وردپرسی، قوانین زیر را در فایل robots.txt توصیه می کنیم :

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-admin/ Disallow: /readme.html Disallow: /refer/ Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

این قطعه کد برای فایل robots از دسترسی به بخش های غیرضروری جلوگیری میکند و همچنین با افزودن نقشه سایت به فایل robots.txt، یافتن تمامی صفحات سایت شما را برای ربات های گوگل آسان می کنید.

اکنون که می دانید یک فایل robots.txt ایده آل چگونه است، بیایید نگاهی به نحوه ایجاد یک فایل robots.txt در وردپرس بیندازیم.

چگونه یک فایل Robots.txt در وردپرس ایجاد کنیم؟

در این مقاله به شما ۲ روش جهت افزودن و ساخت فایل robots.txt به شما معرفی میکنیم که بسته به انتخاب خود میتوانید از یک روش ذکر شده این فایل را بسازید.

روش ۱: ویرایش فایل Robots.txt با استفاده از All in One SEO

All in One SEO که با نام AIOSEO نیز شناخته می شود، بهترین افزونه سئو وردپرس در بازار است که توسط بیش از ۲ میلیون وب سایت استفاده می شود. استفاده از آن آسان است و با یک تولید کننده فایل robots.txt نیز همراه است.

اگر قبلاً افزونه AIOSEO را نصب نکرده اید، می توانید برای راهنمایی دقیق راهنمای گام به گام ما در مورد نحوه نصب افزونه وردپرس را مشاهده کنید.

پس از نصب و فعال سازی افزونه ، می توانید از آن برای ایجاد و ویرایش فایل robots.txt خود به طور مستقیم از پنل پیشخوان وردپرس خود استفاده کنید.

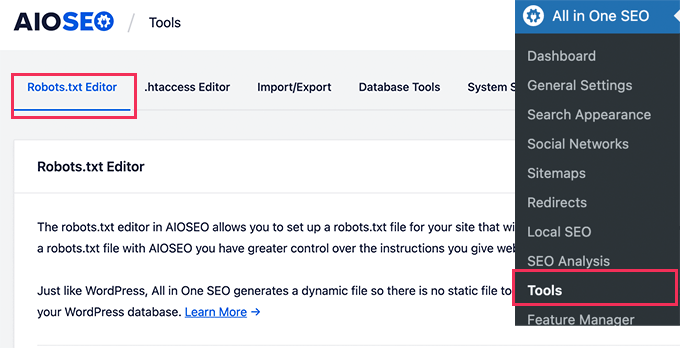

برای ویرایش فایل robots.txt خود کافیست به مسیر All in One SEO » Tools بروید :

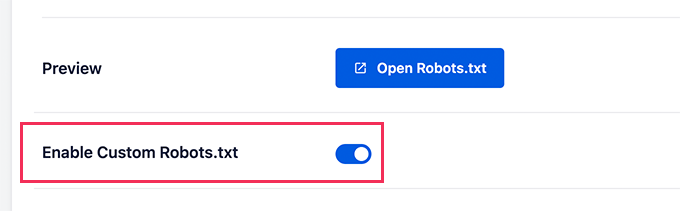

ابتدا باید با کلیک روی گزینه “Enable Custom Robots.txt” آن را فعال و روشن نمایید، تا گزینه آبی روشن شود.

با فعال کردن این مورد، می توانید یک فایل robots.txt سفارشی در وردپرس ایجاد کنید.

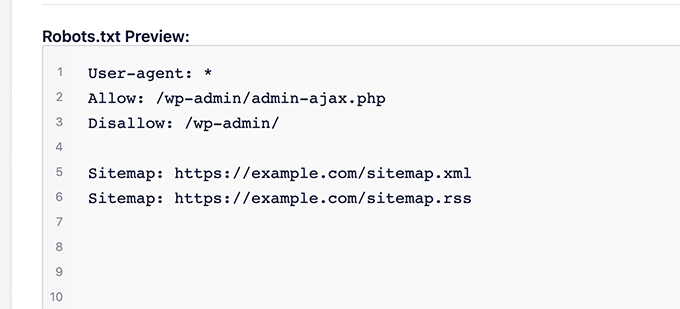

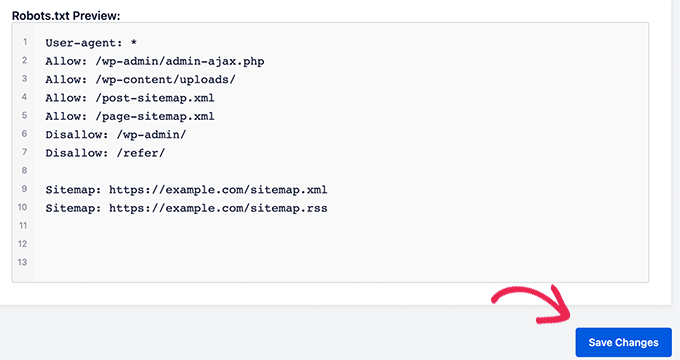

افزونه All in One SEO فایل robots.txt موجود شما را در بخش ‘Robots.txt Preview’ در پایین صفحه نمایش شما نشان میدهد.

این نسخه قوانین پیش فرض اضافه شده توسط وردپرس را نشان می دهد.

این قوانین پیشفرض به موتورهای جستجو میگوید که فایلهای اصلی وردپرس شما را نخوانند، به رباتها اجازه میدهد تمام محتوا را فهرستبندی و ایندکس کنند و پیوندی به نقشههای سایت XML سایت شما در اختیار آنها قرار میدهد.

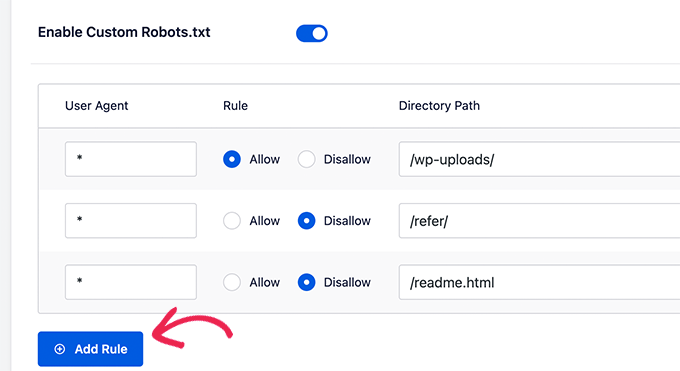

اکنون، می توانید قوانین سفارشی خود را برای بهبود robots.txt برای سئو اضافه کنید.

برای افزودن قانون جدید، یک عامل کاربری در قسمت “User Agent” وارد کنید. استفاده از * این قانون را برای همه اعمال می کند.

سپس، با قرار دادن مقادیر ‘Allow’ یا ‘Disallow’ انتخاب کنید که میخواهید موتور های جستجو را مجاز یا غیرمجاز به دسترسی و خزیدن آن مسیر کنید.

سپس، نام فایل یا مسیر دایرکتوری را در قسمت ‘Directory Path’ وارد کنید.

این قانون به طور خودکار روی robots.txt شما اعمال خواهد شد. برای افزودن یک قانون دیگر روی دکمه «Add Rule» کلیک کنید.

در نهایت قوانین سفارشی شما به این شکل خواهد بود.

پس از اتمام کار، فراموش نکنید که برای ذخیره تغییرات خود بر روی دکمه ‘Save Changes’ کلیک کنید.

روش ۲: ویرایش دستی فایل Robots.txt با استفاده از FTP

برای این روش، باید از یک FTP client برای ویرایش فایل robots.txt استفاده کنید.

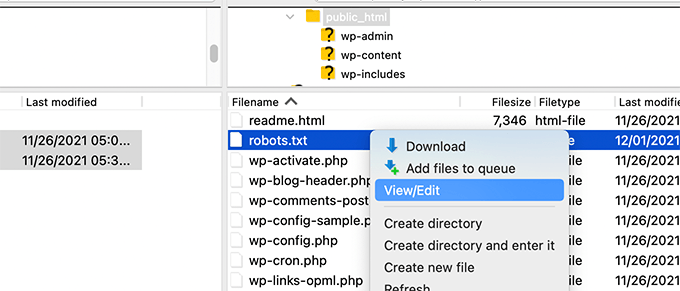

به سادگی با استفاده از یک FTP client به حساب میزبانی وردپرس خود متصل شوید. پس از ورود، می توانید فایل robots.txt را در پوشه ریشه وب یا روت سایت یا public_html خود مشاهده کنید.

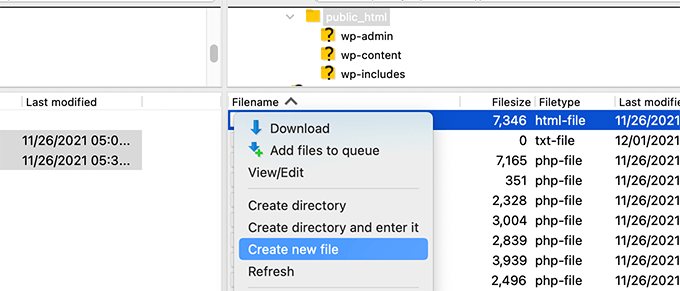

اگر فایلی با نام robots.txt نمیبینید، نیاز است ابتدا یک فایل با همین نام و فرمت بسازید و ادامه آموزش را پیش بروید :

Robots.txt یک فایل متنی ساده است، به این معنی که می توانید آن را در رایانه خود بارگیری کرده و با استفاده از ویرایشگر متن ساده مانند ++Notepad یا TextEdit ویرایش کنید.

در نهایت پس از ذخیره تغییرات، می توانید دوباره آن را در پوشه اصلی وب سایت خود آپلود کنید.

چگونه فایل Robots.txt خود را تست کنیم؟

هنگامی که فایل robots.txt خود را ایجاد کردید، همیشه ایده خوبی است که آن را با استفاده از ابزار تست فایل robots.txt آزمایش کنید.

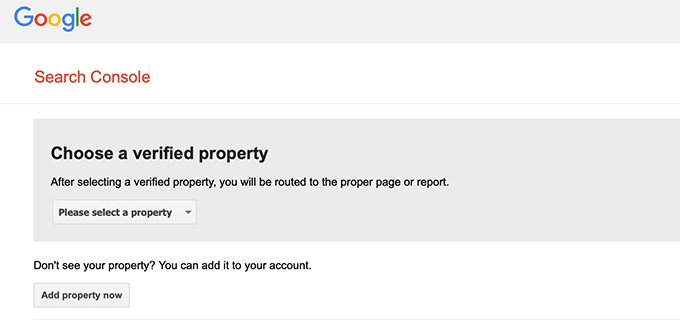

ابزارهای آزمایش کننده robots.txt زیادی وجود دارد، اما توصیه می کنیم از ابزاری که در داخل کنسول جستجوی گوگل قرار دارد استفاده کنید.

برای اینکار، پیشنیاز این است که ابتدا وب سایت خود را با کنسول جستجوی گوگل مرتبط کنید.

سپس، می توانید از ابزار تست فایل robots.txt کنسول جستجوی گوگل یا Google Search Console Robots Testing Tool استفاده کنید.

به سادگی سایت خود را از لیست کشویی انتخاب کنید.

این ابزار به طور خودکار فایل robots.txt وب سایت شما را دریافت می کند و در صورت یافتن خطاها و هشدارها را هایلایت می کند.

امیدواریم این مقاله به شما کمک کند تا یاد بگیرید چگونه فایل robots.txt وردپرس خود را برای سئو بهینه کنید. همچنین ممکن است بخواهید آموزش سئو تصاویر در وردپرس – راهنمای مبتدیان را برای رشد سئو وب سایت خود مشاهده کنید.